Le 15 septembre 2023, Fujitsu et la Fondation Linux ont révélé un partenariat stratégique visant à donner naissance à deux projets open source majeurs dans le domaine de l'intelligence artificielle (IA) et de l'apprentissage automatique (machine learning). Ces projets ont pour objectif de révolutionner le développement de code automatisé.

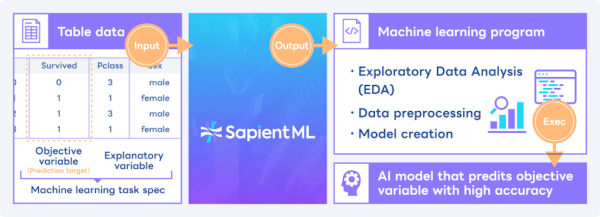

Le premier projet, baptisé SapientML, se concentre sur la conception d'une technologie d'apprentissage automatique (AutoML) novatrice, destinée à générer du code facilitant la création rapide de modèles d'apprentissage automatique à partir de données tabulaires.

Le second projet, baptisé Intersectional Fairness, aborde la question cruciale de l'équité dans l'IA en ciblant la détection et la réduction des biais qui peuvent être présents dans les modèles d'IA, mais qui ne sont pas toujours immédiatement évidents.

Ces deux initiatives revêtent une grande importance pour la Fondation Linux, qui œuvre activement à la promotion de l'IA en open source. Elles offriront aux développeurs du monde entier la possibilité d'explorer ces technologies d'IA et de machine learning, tout en contribuant à leur démocratisation.

SapientML : Simplifier le Développement de Modèles d'IA grâce à l'AutoML

SapientML vise à simplifier le processus de création de modèles d'IA. Il permet aux data scientists de concevoir des modèles précis et interprétables sans avoir à rédiger une seule ligne de code.

Le fonctionnement de la technologie AutoML de SapientML s'articule autour des étapes suivantes :

- Collecte des données : Rassemblement de données à partir de diverses sources, telles que des bases de données, des fichiers CSV ou des API.

- Préparation des données : Traitement des données en vue de leur utilisation dans le cadre de l'apprentissage automatique, incluant la correction des données manquantes, la gestion des erreurs et la normalisation.

- Entraînement du modèle : Formation d'un modèle d'IA à partir des données préparées.

- Évaluation du modèle : Évaluation de la précision du modèle en le testant sur un jeu de données de validation.

- Utilisation du modèle : Mise en application du modèle pour prédire des résultats sur de nouvelles données.

Intersectional Fairness : Lutter contre les Biais dans l'IA

Intersectional Fairness s'attaque au problème crucial de la partialité dans les systèmes d'IA. Son objectif principal est d'identifier et de réduire les biais qui peuvent découler de données d'apprentissage biaisées.

Le processus de la technologie Intersectional Fairness se décline comme suit :

- Identification des biais : Détection des biais présents dans les données d'apprentissage.

- Évaluation des biais : Évaluation de l'impact des biais identifiés sur la précision du modèle.

- Atténuation des biais : Réduction des biais grâce à l'utilisation de techniques d'apprentissage automatique avancées.

En conclusion, les projets SapientML et Intersectional Fairness représentent des avancées cruciales dans la promotion de l'IA en open source. Ils offrent aux développeurs du monde entier l'opportunité d'explorer ces technologies d'IA et de machine learning tout en contribuant à les rendre accessibles à un public plus large, contribuant ainsi à l'évolution continue du domaine de l'IA.

Pages en rapports

- https://github.com/sapientml

- https://github.com/intersectional-fairness

- https://lfaidata.foundation/projects/