L'installation de modèles d'intelligence artificielle comme DeepSeek localement est une étape cruciale pour exploiter pleinement les capacités des grandes langues sans dépendre des services cloud. Dans cet article, nous vous accompagnons pas à pas dans l'installation de DeepSeek via Ollama sur Ubuntu 24.04, tout en ajoutant des améliorations pratiques pour optimiser votre expérience.

Prérequis

Avant de commencer, assurez-vous que votre système répond aux exigences suivantes :

- Système d'exploitation : Ubuntu 24.04 installé.

- Mémoire RAM : Au moins 8 Go (16 Go ou plus recommandés).

- Connexion Internet : Stable et rapide pour télécharger les modèles volumineux.

- Connaissances de base : Familiarité avec le terminal Linux.

Étape 1 : Mise à Jour du Système

Commencez par mettre à jour votre système pour éviter tout problème de compatibilité :

sudo apt update && sudo apt upgrade -yÉtape 2 : Installation de Python, Git et Pip

Assurez-vous que Python (version 3.8 ou supérieure), Git et Pip sont installés. Python est un langage de programmation largement utilisé pour le développement d'applications IA. Git est un outil de gestion de versions qui permet de cloner des dépôts GitHub. Pip est le gestionnaire de paquets Python.

sudo apt install python3 python3-pip git -yÉtape 3 : Installation de Ollama

Ollama est une plateforme qui simplifie l'exécution locale de grands modèles linguistiques en fournissant des outils pour gérer et interagir avec des modèles comme DeepSeek. Installez-le avec la commande suivante :

curl -fsSL https://ollama.com/install.sh | shDémarrez et activez Ollama pour qu'il démarre automatiquement au boot :

sudo systemctl start ollama

sudo systemctl enable ollamaÉtape 4 : Téléchargement et Exécution de DeepSeek

DeepSeek est un modèle avancé d'IA conçu pour des tâches de traitement du langage naturel, comme répondre à des questions ou générer du texte. Téléchargez le modèle via Ollama :

ollama run deepseek-r1:7bCette étape peut prendre plusieurs minutes selon votre connexion Internet. Une fois terminée, vérifiez que le modèle est bien installé :

ollama listÉtape 5 : Interface Web pour DeepSeek

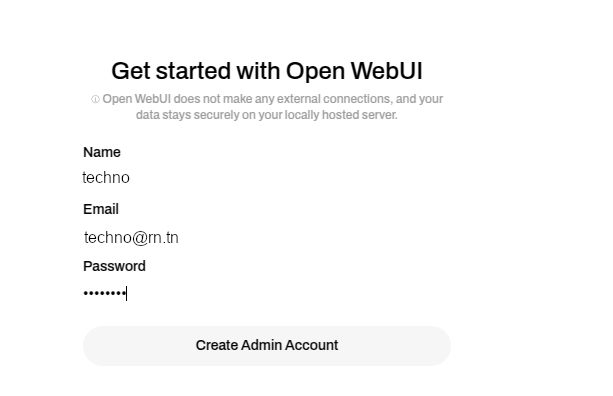

Pour une expérience utilisateur plus conviviale, installez une interface web. Créez d'abord un environnement virtuel pour isoler vos dépendances Python :

sudo apt install python3-venv

python3 -m venv ~/open-webui-venv

source ~/open-webui-venv/bin/activateInstallez ensuite Open WebUI via Pip :

pip install open-webuiDémarrez le serveur :

open-webui serveAccédez ensuite à l'interface web via votre navigateur à l'adresse suivante : http://localhost:8080.

Améliorations et Optimisations

Voici quelques suggestions pour améliorer votre installation :

- Utilisation de GPU : Si votre machine dispose d'une carte graphique NVIDIA, configurez CUDA pour accélérer les calculs.

- Automatisation du Démarrage : Créez un script pour automatiser le démarrage de Ollama et du serveur WebUI.

- Sauvegarde des Modèles : Sauvegardez les modèles pour éviter de les retélécharger en cas de réinstallation.

- Personnalisation de l'Interface Web : Modifiez les paramètres de l'interface web pour adapter son apparence ou ajouter des fonctionnalités spécifiques.

Conclusion

Avec ce guide, vous avez maintenant installé DeepSeek localement sur Ubuntu 24.04 et configuré une interface web conviviale pour interagir avec le modèle. Les améliorations proposées permettent d'optimiser les performances et de personnaliser l'expérience pour répondre à vos besoins spécifiques, notamment dans le domaine médical.

N'hésitez pas à explorer davantage les possibilités offertes par DeepSeek et à partager vos retours pour enrichir cette documentation !